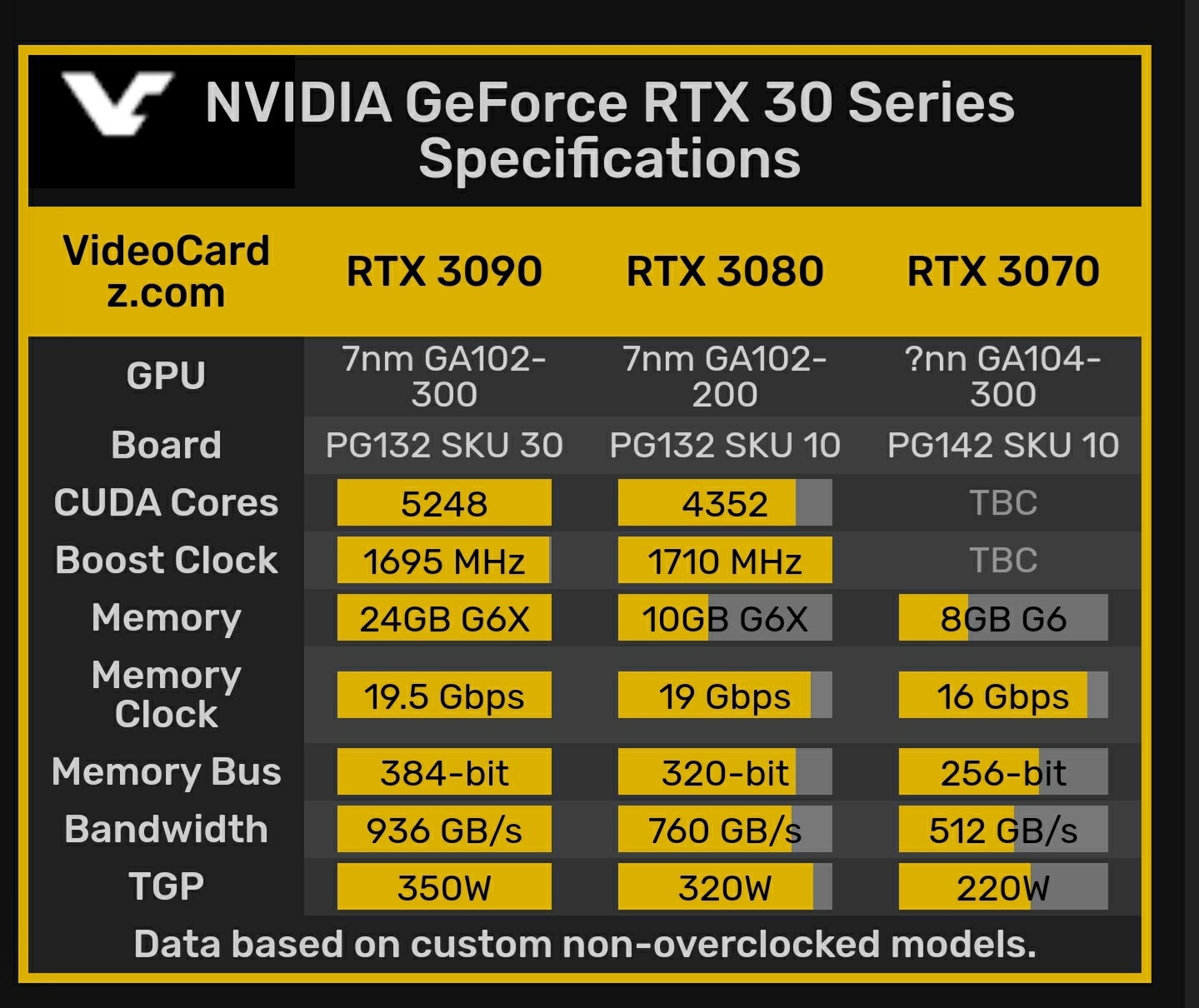

Rein vom Gefühl und der Marktausrichtung her dürfte eine 60er 300€ kosten, eine 70er um die 500, die 80er 650, eine 3090 900€ und die Titan 1200€ kosten.

Nicht wirklich, ich habe damals eine GTX 680 von Asus für 480€ gekauft, inkl. Versand. Neue Features & Development costs gab es schon immer.

Richtig wären die Preise so:

RTX 3060: 249€

RTX 3070: 399€

RTX 3080: 499€

RTX 3090: 599€

RTX Titan: 699€

Ich habe für die erste Titan damals noch 600€ bezahlt. Nvidia versucht halt die Margen so hoch wie möglichst zu halten, frei nach dem Motto "wer 1.200€ für ein Smartphone zahlen kann, der kann auch 1.200€ für eine 2080Ti bezahlen". Es funktioniert auch weil die Enthusiasten, völlig fernab von jeglicher Logik und Hausverstand, einfach jeden Preis zahlen, ohne auf P/L zu schauen. In Zukunft wird das aber sicher nicht mehr so funktionieren, vor allem mit Corona mit dem wir noch lange zu kämpfen haben werden.

Mir persönlich ist es völlig wurscht welche Firma am erfolgreichsten ist und wieviel verkauft, ich bin kein Sklave einer Marke. Mir hat weder Nvidia, Sony, Microsoft, Nintendo oder andere jemals etwas geschenkt, die wollen alle nur unser Geld haben. Aber ich kann euch eines jetzt schon sagen, nämlich dass PC-Gaming mit solchen Preisen wie sie Nvidia fördert definitiv Schaden nehmen wird. Und das darf man nicht falsch verstehen: Während Nvidia ganz sicher wieder neue Rekorde feiern wird, die sie anscheinend mit den oberen 10.000 machen die bereit sind so viel Geld für Grakas zu bezahlen, wird der Software- bzw. Spielemarkt die nächste Gen haushoch von PS5, Switch (2) und Series X dominiert werden. Gerade in Zeiten wie jetzt werden die Leute ganz sicher ein (Gesamt-)System kaufen, das in puncto Preis/Leistung am besten sein wird, und kein Geld verprassen für Grakas mit hohem Stromverbrauch und wenig Speicher.

)

)