Ich sag dir nicht wie günstig meine 3080 war(bilder im smartphone foto thread) aber kaum teurer als die günstigste 3070 auf geizhals derzeit. Hab sie von nem Gamer in top zustand erstanden 1 Jahr alt.

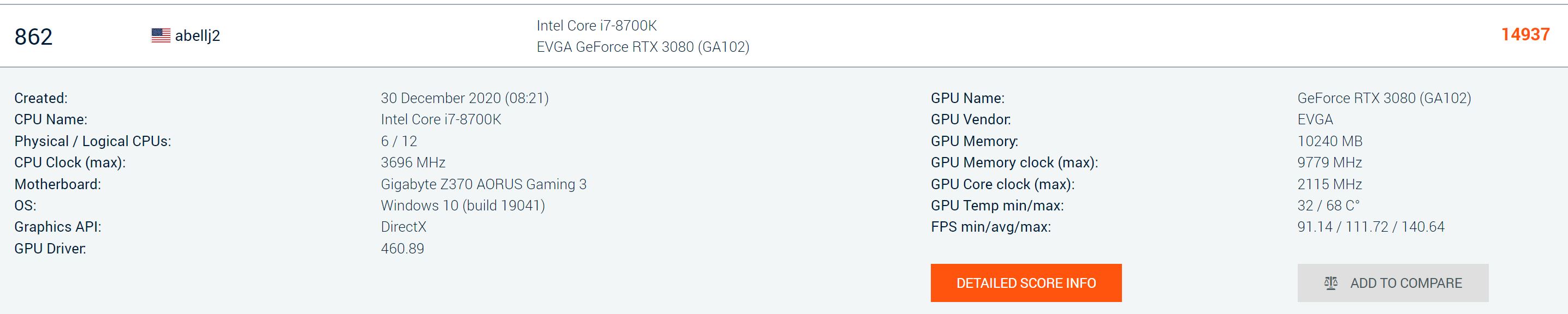

Da das der Frickel Thread ist, habe sie undervolted auf 0.850v und takt auf 1870Mhz gestellt bei 300W Maximalverbrauch hält sie mit Verrückten mit die 2115MHz fahren und wahrscheinlich 350W schlucken, bzw. mein Score ist sogar besser(um 1 Punkt

), zeigt, dass sich Frickeln auszahlt und weniger auch mehr sein kann

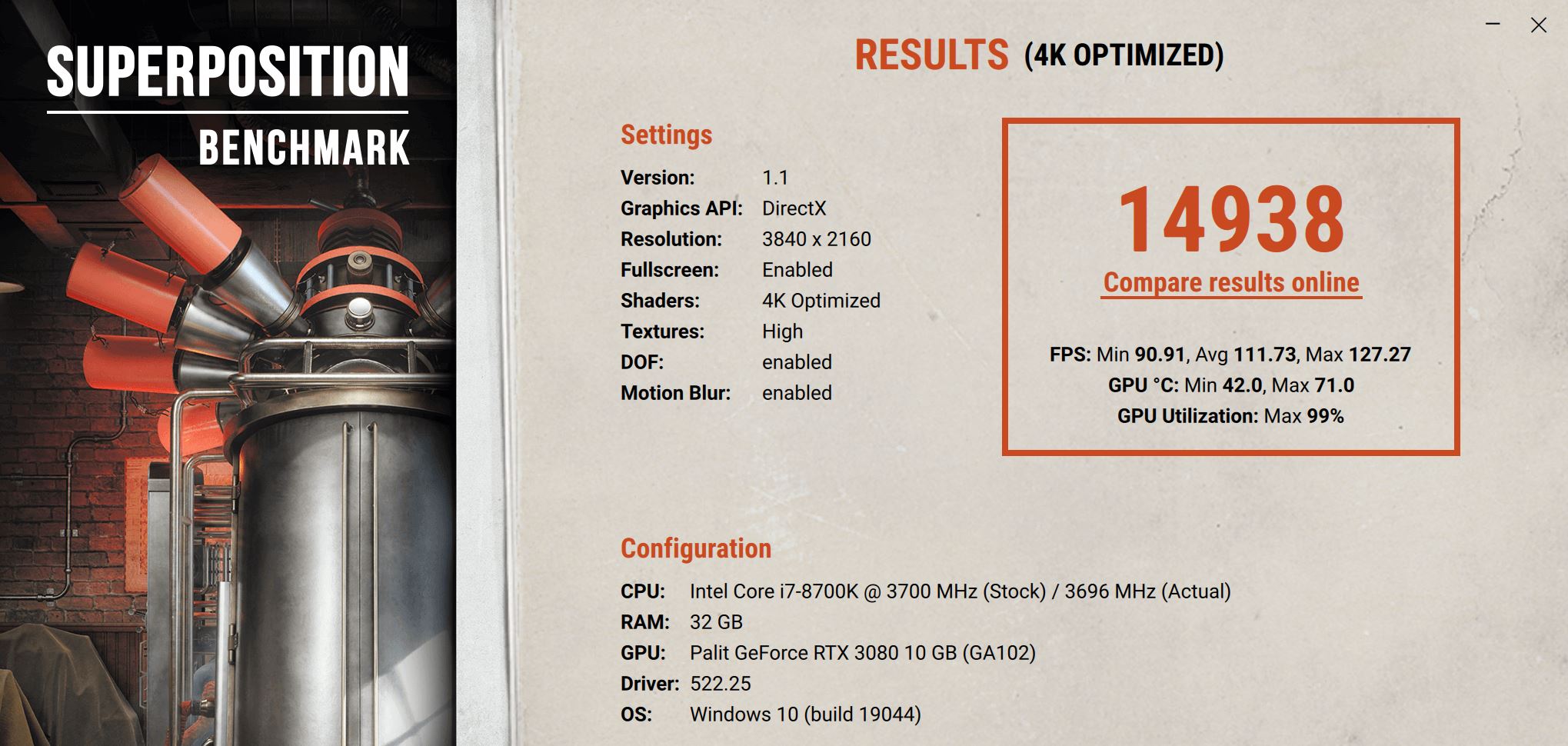

mein ergebnis:

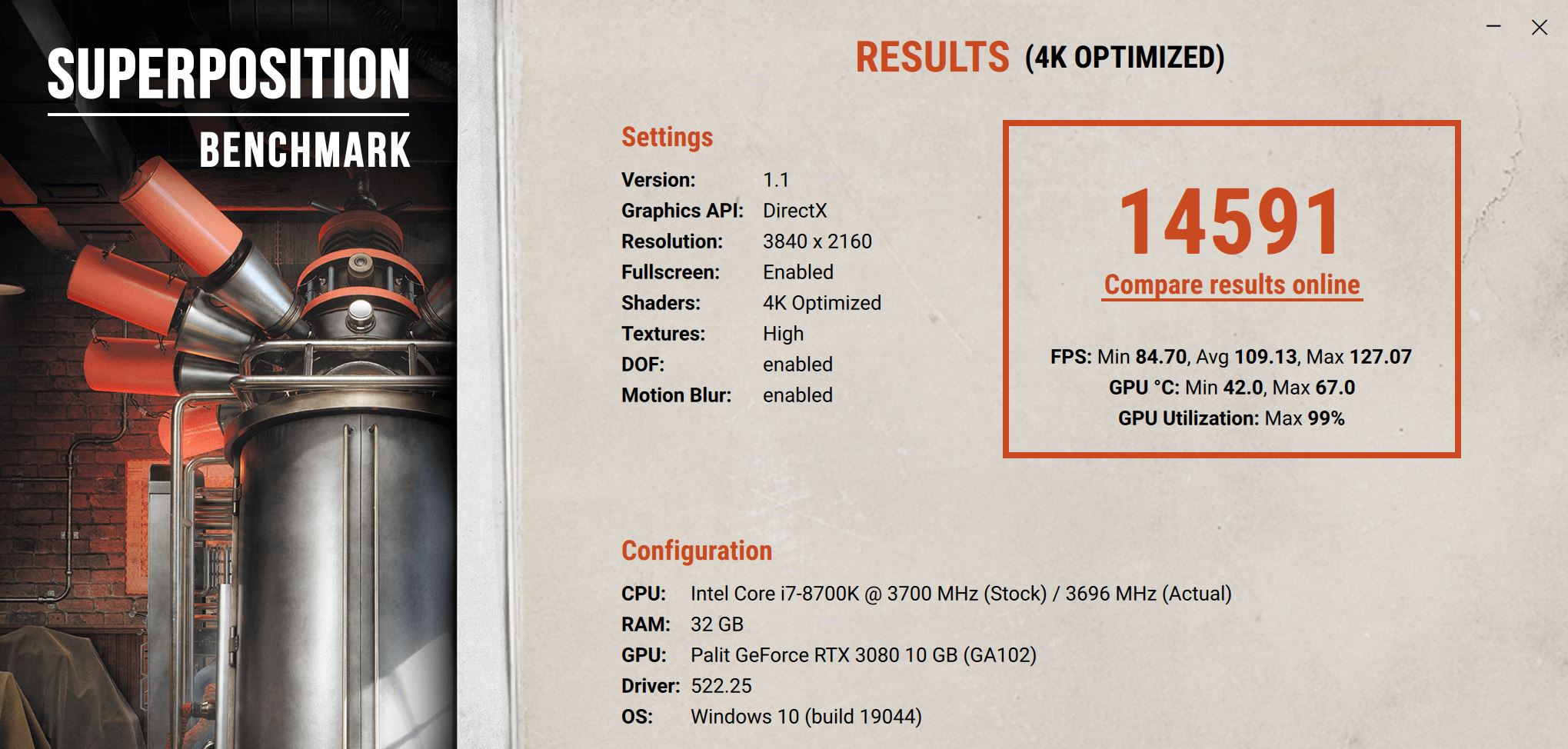

Das kommt übrigens bei 272W Maximalverbrauch heraus(0.815v - 1770-1800MHz)

Ich werde das noch in echten games und mit dem 3DMark testen(hasse den weil der in der kostenlosen Version die dumme Demo Vorab laufen lässt). Aber wahrscheinlich werde ich mit dem 272W Max-Verbrauch spielen(läuft auch 4°C kühler), hab immerhin nur ein 550W Netzteil, wills nicht zu sehr strapazieren. -Außerdem sind das nur schlappe 2,4% durchschnittliche FPS(7% mehr min. FPS) für 10% mehr Stromverbrauch, dürfte den Sweetspot gefunden haben.

Achja, vergleich mit meiner 3060Ti, mit der Hab ich auch Undervolting betrieben, für die 1775-1800MHz 0.855v, es kamen folgende FPS bei 180W Verbrauch heraus: 56,22 / 70,73 / 86,65. Das heißt meine 3080 liefert 54% mehr durchschnittliche FPS bei 50% mehr Stromverbrauch.

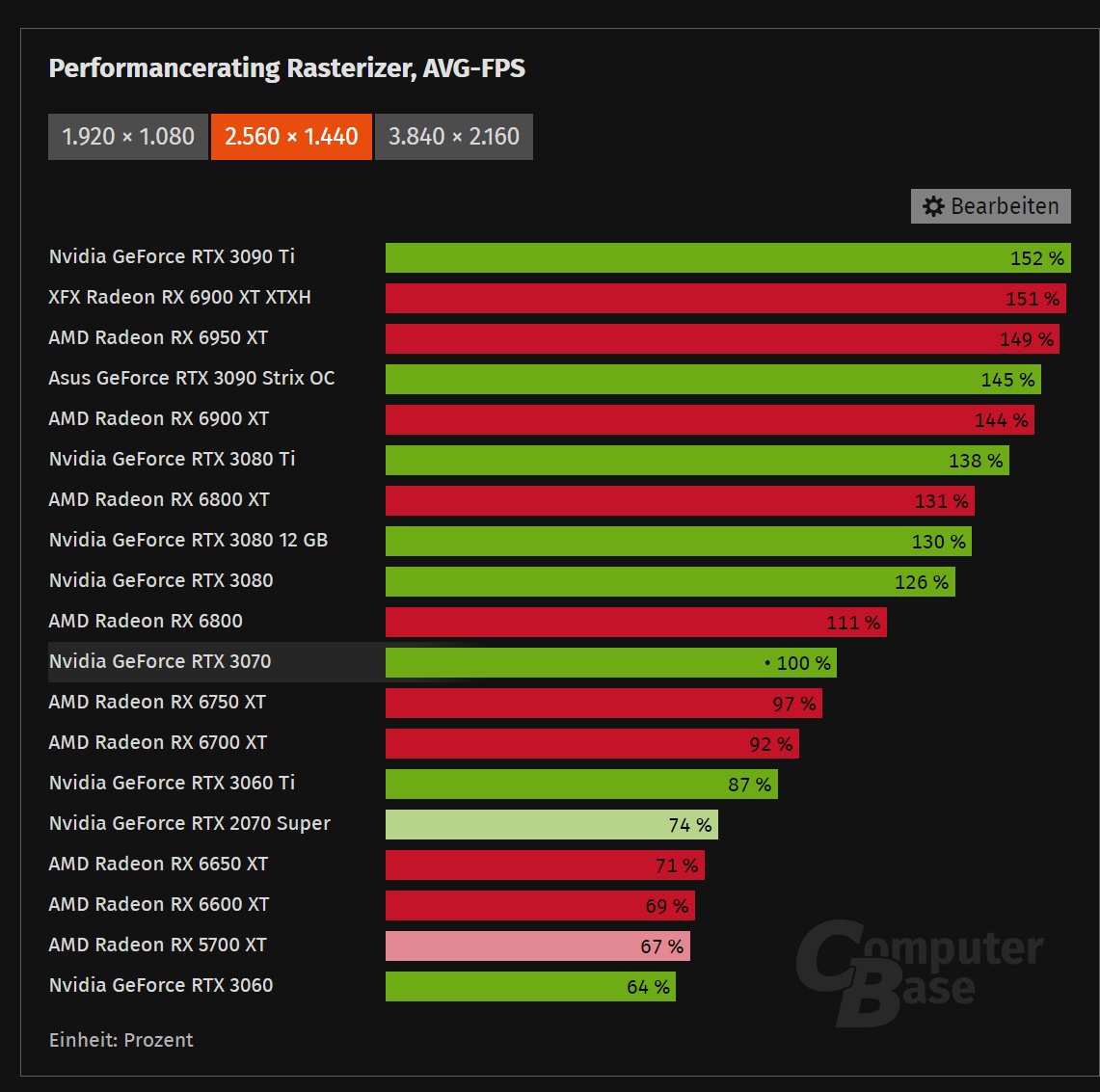

Kann natürlich auf die Vorstellung der RX 7000er warten aber die ersten Karten kommen ja angeblich frühestens Mitte Dezember, werden sich auch viel zu viel Strom genehmigen für meinen Geschmack und sicher auch erstmal nur die High End Modelle für richtig viel Asche. Könnte natürlich auf einen weiteren Preisverfall der RX 6000er setzen aber eine RX 6900 XT ist mir schon zu viel ehrlich gesagt, wird dann auch langsam knapp mit meinem Fractal Ion+ 2 760W

Kann natürlich auf die Vorstellung der RX 7000er warten aber die ersten Karten kommen ja angeblich frühestens Mitte Dezember, werden sich auch viel zu viel Strom genehmigen für meinen Geschmack und sicher auch erstmal nur die High End Modelle für richtig viel Asche. Könnte natürlich auf einen weiteren Preisverfall der RX 6000er setzen aber eine RX 6900 XT ist mir schon zu viel ehrlich gesagt, wird dann auch langsam knapp mit meinem Fractal Ion+ 2 760W ), zeigt, dass sich Frickeln auszahlt und weniger auch mehr sein kann

), zeigt, dass sich Frickeln auszahlt und weniger auch mehr sein kann