Hazuki

L20: Enlightened

- Seit

- 3 Sep 2005

- Beiträge

- 22.231

na bei euch hat sich aber viel angesammelt die jetzt raus muss wa

Power your Dreams

Im folgenden Video siehst du, wie du consolewars als Web-App auf dem Startbildschirm deines Smartphones installieren kannst.

Hinweis: This feature may not be available in some browsers.

na bei euch hat sich aber viel angesammelt die jetzt raus muss wa

Die KI ist eigentlich nicht das Problem, du konntest selbst mit der Last gen KIs programmieren, die aber jedem Menschen deutlich überlegen wäre, durch umlaufen des Spielers etc. Das will man aber auch nicht. Deshalb sucht man meist den MIttelweg, die meisten Gamer nicht zu frustrieren. Man will schließlich massenkompatibel seinWas ich schade finde, ist dass niemand über die K.I. in Games spricht. Dort sollte es mal einen Sprung geben und nicht mit RayTracing scheiss. Klar, man spielt immer mehr online mit echten Menschen aber ein Gears oder Uncharted mit intelligenten Gegnern, würde nicht schaden.

Die KI ist eigentlich nicht das Problem, du konntest selbst mit der Last gen KIs programmieren, die aber jedem Menschen deutlich überlegen wäre, durch umlaufen des Spielers etc. Das will man aber auch nicht. Deshalb sucht man meist den MIttelweg, die meisten Gamer nicht zu frustrieren. Man will schließlich massenkompatibel sein

Die meisten Entwickler sind dabei faul, erhöhen einfach die gegner anzahl, machen aus den Feinden schlucknutten und teilen mehr aus. Trotzdem ist es kein Problem eine gescheite KI zu bringen. Da gabs irgendwo mal ein Interview zu, muss ich morgen mal raussuchenNe, dieses Argument lasse ich nicht gelten. Für was gibt es Schwierigkeitsgrade?

Gute KI heißt halt im Spielekontext nicht einfach starke KI. Letzteres wäre natürlich extrem einfach und auch derzeit schon locker möglich gewesen. Aber eine wirklich glaubhafte KI, die in vielen verschiedenen Szenarien glaubhaft klug und innerhalb menschlicher Fähigkeiten agiert, ist mit Sicherheit extrem schwierig umzusetzen.Die meisten Entwickler sind dabei faul, erhöhen einfach die gegner anzahl, machen aus den Feinden schlucknutten und teilen mehr aus. Trotzdem ist es kein Problem eine gescheite KI zu bringen. Da gabs irgendwo mal ein Interview zu, muss ich morgen mal raussuchen

Was ich schade finde, ist dass niemand über die K.I. in Games spricht. Dort sollte es mal einen Sprung geben und nicht mit RayTracing scheiss. Klar, man spielt immer mehr online mit echten Menschen aber ein Gears oder Uncharted mit intelligenten Gegnern, würde nicht schaden.

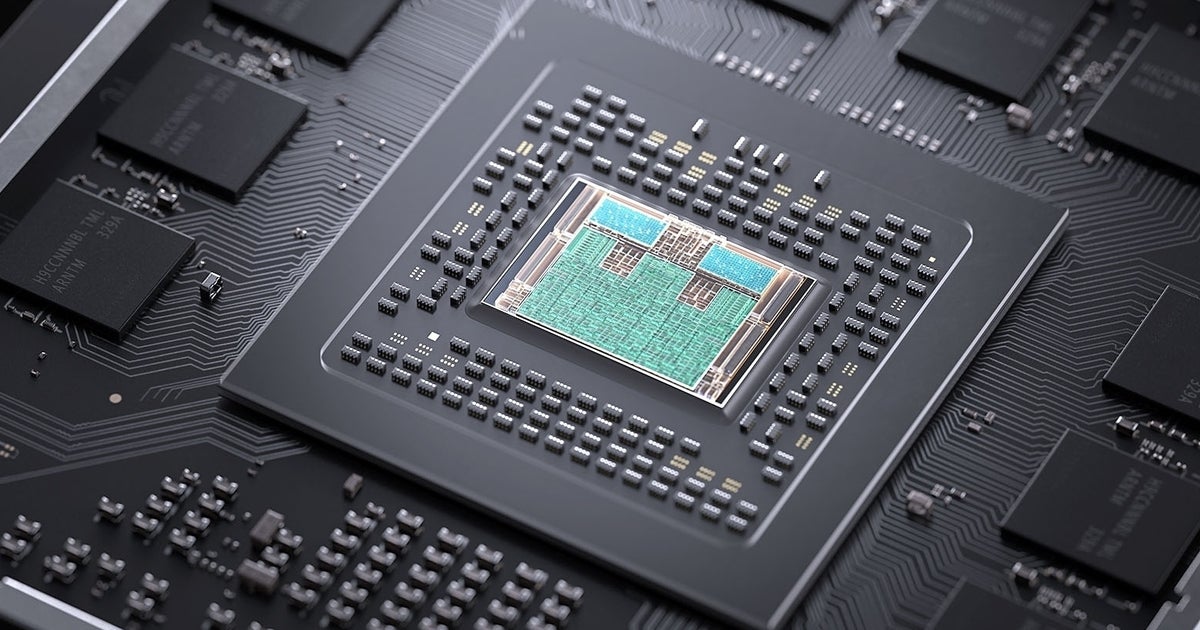

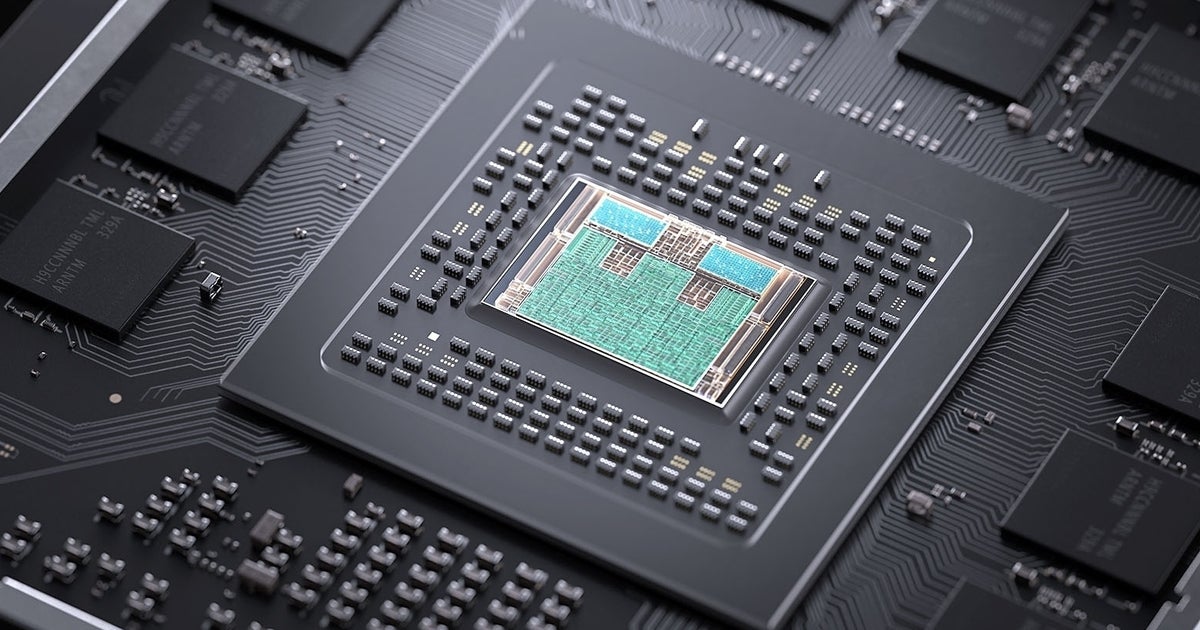

DirectML

Xbox Series X unterstützt Machine Learning in Spielen mit DirectML. DirectML ist Teil von DirectX und nutzt die hohe Hardwareleistung der Xbox Series X und profitiert von über 24 TFLOPS bei 16-bit-Float Performance Berechnungen und mehr als 97 TOPS (Billion Berechnungen pro Sekunde) bei 4-bit Integer Berechnungen. Machine Learning kann viele Bereiche in Spielen verbessern, wie z.B. die Intelligenz von NPCs, beim Anzeigen von lebensechteren Animationen oder bei der Verbesserung der Grafikqualität.

Andererseits kann ich mir auch nicht vorstellen, dass MS nicht

A) ebenfalls Entwicker gefragt hat

B) sie nicht ausgelotet haben, welche Geschwindigkeit eine SSD haben muss, um eben keine Ladezeiten und Pop ups /ins haben zu müssen.

ihre devs entwickeln mit so ner SSD als basis und da bin ich gespannt drauf.

ihre devs entwickeln mit so ner SSD als basis und da bin ich gespannt drauf.Kein klassischer Boost, aber ein Boost.Was meinst du genau?

Die PS5 hat Power Managment. Das ist (oder wird ?) in den neuen AMD Karten Standard.

Kein klassischer Boostmodus

Gut, Win bootet nicht in 10GB rein und Online wartet man noch auf die Server.Davon ging ich übrigens auch aus, bei aktuellen Spielen merke ich kaum vorteile meiner 4000MB/s NVME, allerdings habe ich jetzt Windows draufgespielt und WTF... Schalte den PC ein, die SSD bootet ca. 7 sekunden nachdem das BootLogo vom Bios verschwindet. Die NVME allerdings... 1 Sekunde ca. total irre.

Wenn Spiele in Zukunft darauf optimiert werden, wirds wohl wirklich keine Ladezeiten mehr geben.

Also ist es jetzt nice?Einfach smart shift video von AMD schauen

) statt immer 2.0GHz bei 36CU

) statt immer 2.0GHz bei 36CU

Die KI ist eigentlich nicht das Problem, du konntest selbst mit der Last gen KIs programmieren, die aber jedem Menschen deutlich überlegen wäre, durch umlaufen des Spielers etc. Das will man aber auch nicht. Deshalb sucht man meist den MIttelweg, die meisten Gamer nicht zu frustrieren. Man will schließlich massenkompatibel sein

Ist halt umgekehrter Boost, also nicht rauf bei Bedarf, sondern runter.Laut AMD ist smart shift nice und ein vorteil den sie gegenüber NV haben werden laut ihnen

Das die PS5 im worst case die Temperatur der APU regeln muss nicht imo. Was ja nicht 10% takt wird, verstehen nur manche nicht.

Die APU läuft aber standart mäßig sonst immer mit höchstem takt und daher "capped" und kein boost wie man es vom PC kennt.

Wird wohl wie wenn du in benchmarks von DF 98% 30 oder 60fps hast und ab und zu dips imo.

Ich sehe es so, lieber hab ich selbst 90% 2.2GHz auf ner 36CU APU (was schon verrückt ist) statt immer 2.0GHz bei 36CU

Also so ganz bin ich von Cernys Aussage noch nicht überzeugt.Laut AMD ist smart shift nice und ein vorteil den sie gegenüber NV haben werden laut ihnen

Das die PS5 im worst case die Temperatur der APU regeln muss nicht imo. Was ja nicht 10% takt wird, verstehen nur manche nicht.

Die APU läuft aber standart mäßig sonst immer mit höchstem takt und daher "capped" und kein boost wie man es vom PC kennt.

Wird wohl wie wenn du in benchmarks von DF 98% 30 oder 60fps hast und ab und zu dips imo.

Ich sehe es so, lieber hab ich selbst 90% 2.2GHz auf ner 36CU APU (was schon verrückt ist) statt immer 2.0GHz bei 36CU

Ist halt umgekehrter Boost, also nicht rauf bei Bedarf, sondern runter.

Meine hier natürlich im Konsolenkontext. Da bestand ja noch vor Kurzem die Meinung das wäre nichts dafür und auch doof für Entwickler.

Aber ja es ist anscheinend nicht viel was korrigiert wird. Viel merken dürfte man nicht.

Btw:

PlayStation 5 vs Xbox Series X specs: CPU, GPU, storage and more compared

This is the essential PlayStation 5 vs Xbox Series X specs comparison: CPU, GPU, storage, backwards compatibility and more compared by Digital Foundry.www.eurogamer.net

Das Problem beim normalen Boost ist folgendes.

Je nach Umgebung taktet die Komponente hoch oder runter.

Es kommt auf die termische Beanspruchung an.

Man kann nicht vorhersagen, wie die Komponente in einer bestimmten Umgebung sich verhält.

Weiterhin ist dadurch der Boostmodus auch nur auf eine beschränkte Zeit möglich, da ja durch den Boost eben die Temperatur ansteigt.

Das ist bei einer Konsole somit ein NO-GO

Das Leistungsmanagment der neuen Desktop AMD APUs und der PS5 APU verhält sich aber komplett anders.

Man sagt dem System, welche maximale Verlustleistung es haben darf unabhängig von der Temperatur. Darauf muss das Kühlsystem hin entwickelt werden.

Und damit ist ein nachvollziehbares Szenario geschaffen.

Die Gesamtverlsustleistung der APU beträgt z.B. 180 Watt.

Die GPU benöitgt bei vollem Takt und Auslastung davon 170 Watt

Die CPU in dem Beispiel dann 20 Watt.

Dreht die GPU voll auf, bleibt für die CPU nur noch 10 Watt übrig.

Dreht die CPU auf, darf sich die GPU nur noch 160 Watt gönnen.

Könnte aber auch sein, dass die GPU bei voller Auslastung und höchstem Takt schon die 180 Watt erreicht.

Dann wäre natürlich nix mehr für die CPU drin. Die wäre damit sicherlich nicht einverstanden

Somit müsste man dann also den Takt runterschrauben, damit die Verlustleistung niedriger ausfällt.

Ist natürlich nur ein Beispiel

Keine Ahnung, wie die genauen Verhältnisse von CPU zu GPU bei der PS5 sind.

Ergibt das nur für mich überhaupt keinen Sinn?!?

Die PlayStation 5 wird ein neues System zur Minimierung von Lüftergeräuschen verwenden. Das bestätigt Lead System Architect Mark Cerny in seiner Präsentation The Road to PS5.

Cerny erklärte, dass die Konsole jetzt eine feste Leistung beim Spielen zusammen mit einer "variablen Frequenz" verwenden wird. Dies führt zu einem Kühlsystem, das nicht "hochdreht", denn die Menge der verbrauchten Energie bleibt jetzt immer gleich.