thraker

L15: Wise

- Seit

- 1 März 2009

- Beiträge

- 9.205

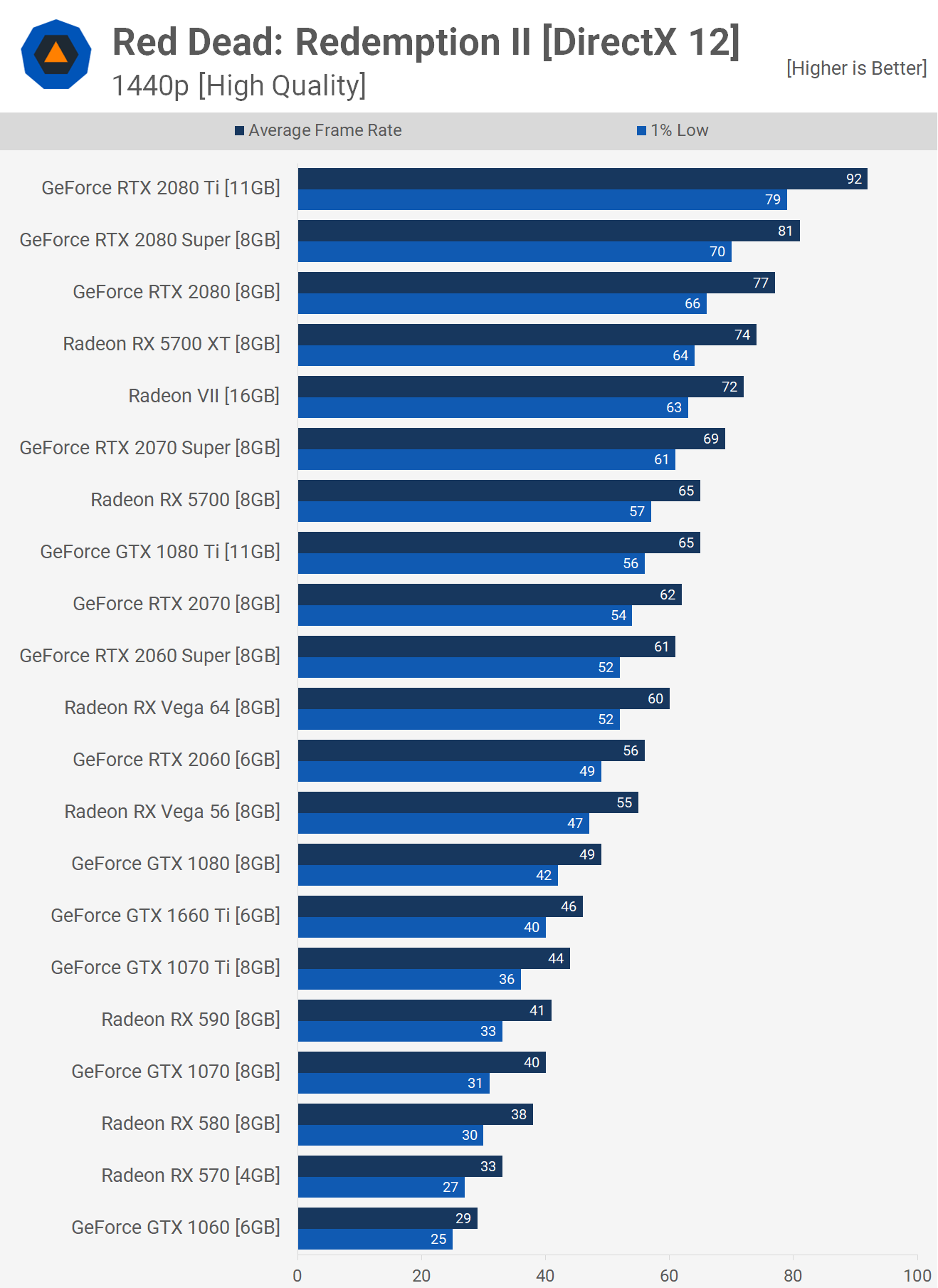

Ich habe eine normale gtx 1080 und einen 1440p 16:9 Bildschirm. Wie gut würde das Spiel bei mir laufen? Hat jemand Erfahrung mit einem vergleichbaren System?

Hier hast du einen gewissen Überblick

oder hier

Red Dead Redemption 2 PC: Western-Epos mit DX12 und Vulkan im Technik-Test [Max-Detail-Update]

Jetzt aktualisiert: RDR2 PC zum Release im Benchmark-Test bei PCGH.

Zuletzt bearbeitet: