Anmelden

?

App installieren

So installierst du die App auf iOS

Im folgenden Video siehst du, wie du consolewars als Web-App auf dem Startbildschirm deines Smartphones installieren kannst.

Hinweis: This feature may not be available in some browsers.

You are using an out of date browser. It may not display this or other websites correctly.

You should upgrade or use an alternative browser.

You should upgrade or use an alternative browser.

PC-Gaming-Hardware | Was gibt es neues auf dem Markt?

- Thread-Ersteller Heavenraiser

- Erstellungsdatum

-

- Tags

- hardware

TheProphet

L99: LIMIT BREAKER

- Seit

- 30 Apr 2002

- Beiträge

- 62.569

Stand nicht dabei, ziemlich sicher SP, man will ja vergleichbare szenarien abspielen.War das jetzt ein Test Online oder Single Player?

Hier was interessantes bzgl. VRAM, man beachte die 2080, die 8GB bottlenecken bei 4k und Maximum Texturen, wenn sie etwas runtergesetzt werden auf Ultra sieht es anders aus:

Hier die gesamte Performance über 14 Games:

Fazit für mich: Gute Steigerung zur 2080Ti, aber erkauft mit deutlich höherer Stromaufnahme:

8% Effizienzsteigerung zur 2080Ti...

Hier übrigens das ganze Video:

Zuletzt bearbeitet:

ChoosenOne

L20: Enlightened

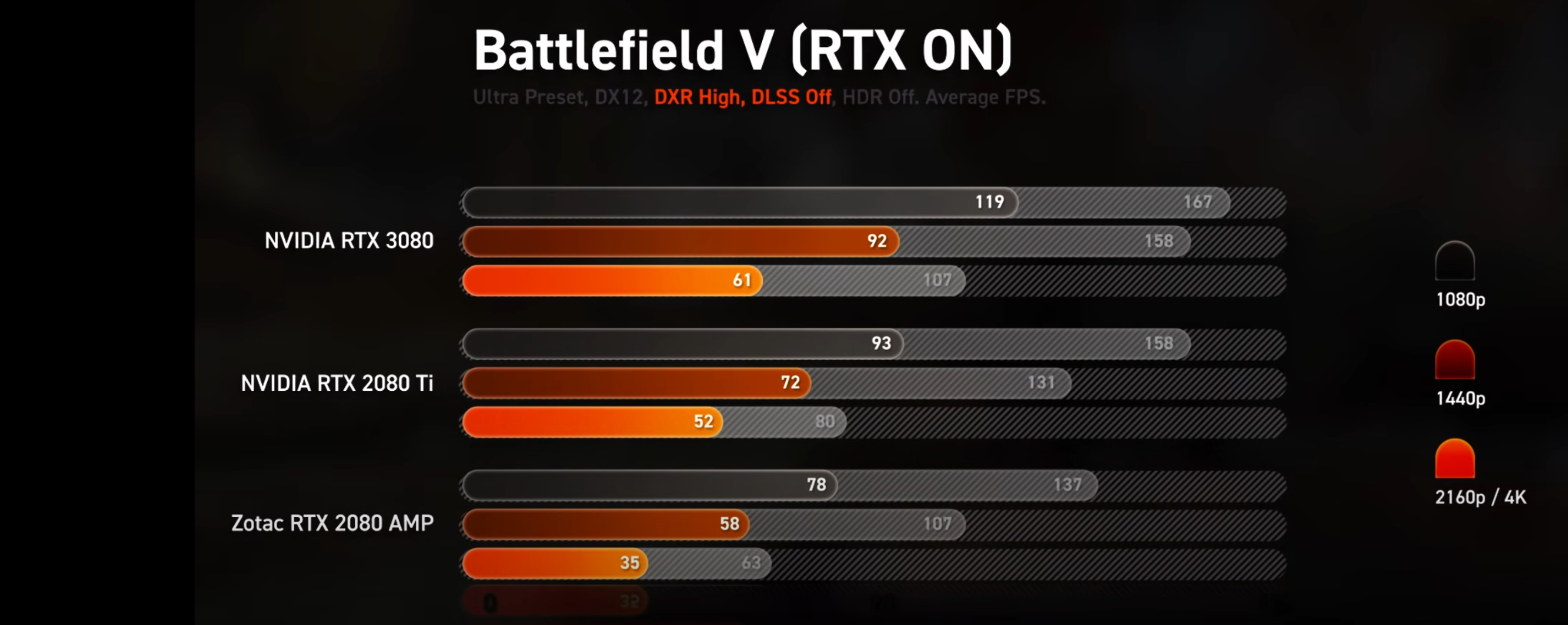

Also das Ergebnis sieht garnicht mal so gut aus:

Dachte mit Raytracing holt man mehr raus

Aber mal bei HW unboxed reinschauen:

DLSS off

Havok

L11: Insane

- Seit

- 27 Feb 2008

- Beiträge

- 1.774

Bis zu 330W (und noch mehr mit Bios tweaks) nur für die GPU ist schon extrem, sogar mehr als bei "Thermi" wie es früher deswegen immer genannt wurde. Finde ich trotz "brandneuer" Architektur doch schon sehr ernüchternd.Fazit für mich: Gute Steigerung zur 2080Ti, aber erkauft mit deutlich höherer Stromaufnahme

Brubi

L15: Wise

- Seit

- 28 Dez 2005

- Beiträge

- 7.552

Bis zu 330W (und noch mehr mit Bios tweaks) nur für die GPU ist schon extrem, sogar mehr als bei "Thermi" wie es früher deswegen immer genannt wurde. Finde ich trotz "brandneuer" Architektur doch schon sehr ernüchternd.

Teils dem Samsung Prozess zu verdanken aber vor allem wegen dem GDDR6X Speicher.

Wäre ja ein leichtes da ordentlich an Strom zu sparen und Bandbreite zu steigern, HBM2 Speicher.

Schade das Nvidia das nicht nahm ;(

Amuro

L99: LIMIT BREAKER

- Seit

- 13 Jun 2007

- Beiträge

- 83.540

bei Current Gen Titeln stimmt dasAlso auf PCI-E 4.0 aufzurüsten ist die kommende Gen absolut nicht notwendig.

Ansonsten: tja, so wie es aussieht, wird meine 2080ti noch bis zur 40er Reihe durchhalten (oder auch nicht)

Havok

L11: Insane

- Seit

- 27 Feb 2008

- Beiträge

- 1.774

Locker. Und dann kannst gleich ein neues 1000W Netzteil zusammen mit der RTX 4080 kaufenAnsonsten: tja, so wie es aussieht, wird meine 2080ti noch bis zur 40er Reihe durchhalten (oder auch nicht)

Amuro

L99: LIMIT BREAKER

- Seit

- 13 Jun 2007

- Beiträge

- 83.540

sureLocker. Und dann kannst gleich ein neues 1000W Netzteil zusammen mit der RTX 4080 kaufen

thraker

L15: Wise

- Seit

- 1 März 2009

- Beiträge

- 9.109

Also 30% ungefähr auf die 2080TI, dabei kann man wohl die TI besser OC. In zukünftigen Spielen wird die sich bestimmt besser absetzen können aber aktuell ist halt wie wohl erwartet. Ich muss mal gucken/suchen, wenn beide voll OC's sind, was da die Differenz ist.

TheProphet

L99: LIMIT BREAKER

- Seit

- 30 Apr 2002

- Beiträge

- 62.569

Ne, die Steigerung, selbst bei diesem schlecht optimierten game wirklich unnötig. Hat schon seine Gründe, warum Nvidia ihre internen Benchmarks nicht auf AMD CPUs gemacht hat, weil die, wie sie selbst im Q&A sagten, trotz PCIE 4 nicht das beste Ergebnis brachten.

Also auf PCI-E 4.0 aufzurüsten ist die kommende Gen absolut nicht notwendig.

Vielleicht mit der nächsten Grafikkartengeneration. Bis dahin hat Intel aber wohl auch PCIE 4.0.

Schluckt dafür auch knapp doppelt soviel Strom(180W mehr)... Bin im selben Boot mit meiner 1070Ti, ist bissl langsamer als deine 1080. Bin bisher nicht überzeugt, glaube ich warte noch ab oder hole mir ne günstige 2080Ti später...Also ich mit meiner GTX 1080 bin sehr zufrieden mit dem Leistungsanstieg

Übrigens an alle die von nem 8700K oder höher auf nen Ryzen umsteigen wollen, weil PCI E 4:

AMD CPUs sind einfach nichts fürs High Refresh Rate Gaming, aber man kann sicher nebenbei gut Video-Encoding betreiben

Zuletzt bearbeitet:

ChoosenOne

L20: Enlightened

Ne, die Steigerung, selbst bei diesem schlecht optimierten game wirklich unnötig. Vielleicht mit der nächsten Grafikkartengeneration.

Schluckt dafür auch knapp doppelt soviel Strom(180W mehr)... Bin im selben Boot mit meiner 1070Ti, ist bissl langsamer als deine 1080. Bin bisher nicht überzeugt, glaube ich warte noch ab oder hole mir ne günstige 2080Ti später...

Übrigens an alle die von nem 8700K oder höher auf nen Ryzen umsteigen wollen, weil PCI E 4:

AMD CPUs sind einfach nichts fürs High Refresh Rate Gaming, aber man kann sicher nebenbei gut Video-Encoding betreiben

Wette der Unterschied bei den CPUs würde bei weitem geringer wen die Auflösung höher währ (4K)

Zuletzt bearbeitet:

TheProphet

L99: LIMIT BREAKER

- Seit

- 30 Apr 2002

- Beiträge

- 62.569

Auf 4k gibts keinen Unterschied weil da die GPU limitiert, ja sogar ne 3080. Wer aber wirklich auf 4K 144hz spielen wollen würde(Grafiksettings reduzieren), könnte das mit einem AMD CPU halt trotzdem nicht so flüssig, weil der auch da logischerweise weniger FPS liefert. Ist eigentlich ganz einfach.Wetter der Unterschied bei den CPUs würde bei weitem geringer wen die Auflösung höher währ (4K)

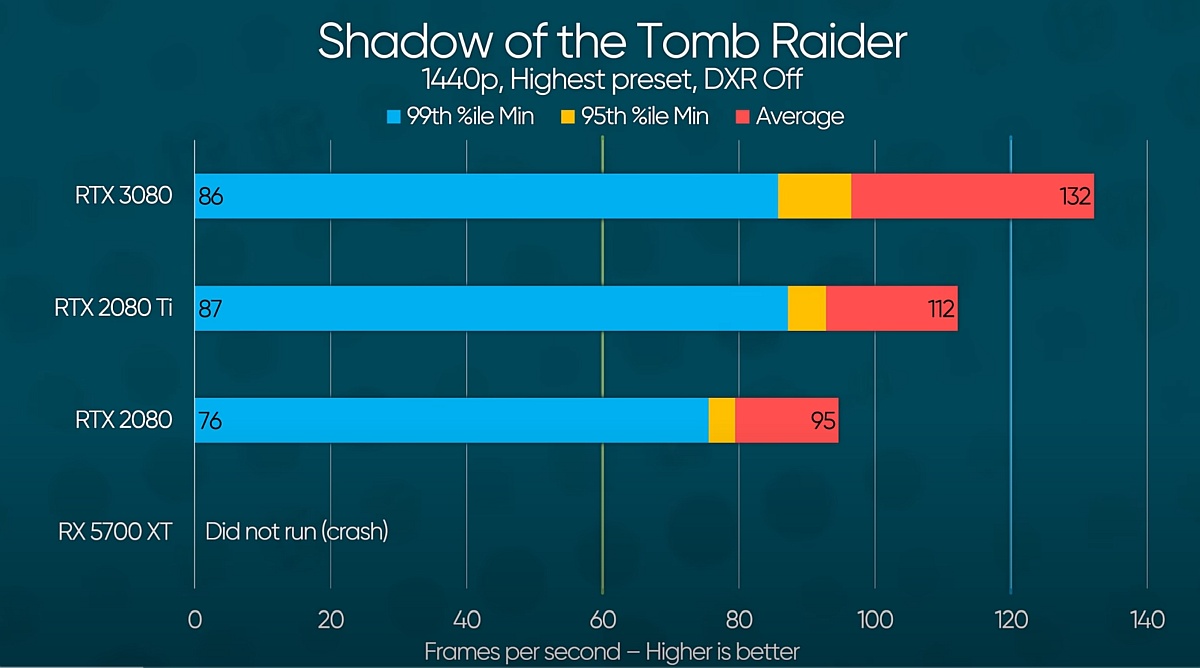

hier übrigens was witziges für @MrBlonde der sicher gerne die Vergleiche zwischen seiner 5700XT und der 3080 sehen würde, Linus hats getestet:

*Geiles Marketing für AMD, recht beliebter AAA Titel und dann das

Morbol

L12: Crazy

- Seit

- 10 Sep 2008

- Beiträge

- 2.556

Bis zu 330W (und noch mehr mit Bios tweaks) nur für die GPU ist schon extrem, sogar mehr als bei "Thermi" wie es früher deswegen immer genannt wurde. Finde ich trotz "brandneuer" Architektur doch schon sehr ernüchternd.

Die Effizienz wurde aber trotzdem gesteigert, die kommen langsam echt an Grenzen ähnlich wie bei den CPUs.

TheProphet

L99: LIMIT BREAKER

- Seit

- 30 Apr 2002

- Beiträge

- 62.569

Laut Computerbase kann man das Power Target um satte 50W runtersetzen und man erhält nur ein paar FPS weniger aber eben ne wesentlich bessere Effizienz. Die Grafik von Nvidia bei der Präsentation ist auch irreführend, die 1,9x Effizienzsteigerung ist nämlich bei 220W und nicht 320W vorhanden. Wer also ne effiziente Karte haben will, setzt das Powerlimit auf 85% oder so.Die Effizienz wurde aber trotzdem gesteigert, die kommen langsam echt an Grenzen ähnlich wie bei den CPUs.

Bei 270W ist die Effizienz 20% gesteigert zur 2080Ti(das heißt auch 20% schneller):

ChoosenOne

L20: Enlightened

Auf 4k gibts keinen Unterschied weil da die GPU limitiert, ja sogar ne 3080. Wer aber wirklich auf 4K 144hz spielen wollen würde(Grafiksettings reduzieren), könnte das mit einem AMD CPU halt trotzdem nicht so flüssig, weil der auch da logischerweise weniger FPS liefert. Ist eigentlich ganz einfach.

hier übrigens was witziges für @MrBlonde der sicher gerne die Vergleiche zwischen seiner 5700XT und der 3080 sehen würde, Linus hats getestet:

*Geiles Marketing für AMD, recht beliebter AAA Titel und dann das

Zum Video:

Ein weiterer Paeudo Experte der die NV Präsentation der 3080 nicht verstanden hat oder aber für billige Clickbait yt Videos falsch darstellt um Klicks abzufischen.

Ich tippe auf letzteres und du bist dem auf den leim gegangen

TheProphet

L99: LIMIT BREAKER

- Seit

- 30 Apr 2002

- Beiträge

- 62.569

Inwiefern soll ich ihm auf den Leim gegangen sein, habe nichts von seinem Content kommentiert, lediglich das eine Slide für MrBlonde gepostet? Das ist ein Tech-Youtuber mit 10 Mio Abonnenten, das wirkt natürlich super wenn direkt das erste Slide mit nem Crash der 5700XT startetZum Video:

Ein weiterer Paeudo Experte der die NV Präsentation der 3080 nicht verstanden hat oder aber für billige Clickbait yt Videos falsch darstellt um Klicks abzufischen.

Ich tippe auf letzteres und du bist dem auf den leim gegangen

Ändert übrigens nichts an meiner vorangegangenen Aussage, dass AMD CPUs eben unnötige Geldverschwendung fürs Gaming sind, trotz PCI-E 4.0.

ChoosenOne

L20: Enlightened

Inwiefern soll ich ihm auf den Leim gegangen sein, habe nichts von seinem Content kommentiert, lediglich das eine Slide für MrBlonde gepostet? Das ist ein Tech-Youtuber mit 10 Mio Abonnenten, das wirkt natürlich super wenn direkt das erste Slide mit nem Crash der 5700XT startet

Ändert übrigens nichts an meiner vorangegangenen Aussage, dass AMD CPUs eben unnötige Geldverschwendung fürs Gaming sind, trotz PCI-E 4.0.

Tatsächlich habe ich dich missverstanden, sorry.

Ging mir direkt um den Anfang des Videos und dieses slides, da aber um seine billige clickbait " aba aba Nvideo hat uns doch doppelte Geschwindigkeit zur 2080ti versprochen omegafail".

Hört man ja in dem Zusammenhang ja leider öfter.

Ich kenn den Typen nicht aber ich versuche auch immer pseudo tech youtuber dieser größe zu meiden. Habe festgestellt das diese meist durch tendeniöse, unsachlich und unseriöse betichte zustande kommt ... dafür aber Show und clickbait bieten.

Hab da bessere Erfahrungen mit "kleineren" tech youtubern gemacht mit einer größe um 100k rum

TheProphet

L99: LIMIT BREAKER

- Seit

- 30 Apr 2002

- Beiträge

- 62.569

Ja, das Video kannst vergessen, habs nur der Vollständigkeit halber mitgeschickt im Spoiler, der Linus weiß aber schon was er macht(meistens) und klar clickbaited der, die Leute stehen leider drauf, deshalb hat er auch 10M Subs.Ging mir direkt um den Anfang des Videos und dieses slides, da aber um seine billige clickbait " aba aba Nvideo hat uns doch doppelte Geschwindigkeit zur 2080ti versprochen omegafail".

Wenn wirklich gute Videos sehen willst dann lieber das:

oder das(der clickbaited zwar auch aber liefert immerhin auch):