Ja, meine These ist bestätigt. Keines der Spiele benötigt auf einmal 4GB mehr RAM, nur weil die Auflösung von 1080p auf 4K geschaltet wurde.

Deine Prozentrechnung ist natürlich falsch, da sie den System-RAM konplett außer Acht lässt und damit Rechnung völlig verschiebt.

Wenn ein Spiel bei 1080p 8GB an VRAM nutzt, dann braucht es eben im Schnitt bei 4K gut 3GB mehr.

Dann schraubt man noch etwas an der allgemeinen Grafik, was problemlos bei jeder Engine geht und schwupp hat man 4GB eingespart.

Sollte ein Spiel viel weniger Speicher brauchen, stört es erst rechnt nicht, wenn die eine Kiste weniger hat.

Der Systemramverbrauch ändert sich mit der Auflösung ja nicht. Also braucht man ihn folglich auch nicht in die Rechnung mit einbeziehen.

Es bleibt also nur die Frage, wie hoch die prozentuale Differenz beider Maschinen beim Speicher sein wird, Ist diese zu hoch, muss man sicherlich etwas Tricksen bei der schwächeren. Aber sollte so eine schwächere Maschine wirklich existieren kann man wohl davon ausgehen, dass das die Ingeneure von MS auch schon alles berücksichtigt haben.

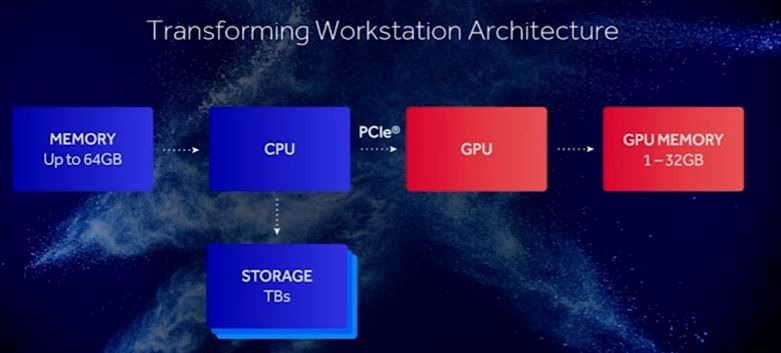

Auf den PC gibt es den Vorteil, dass im System-RAM ausgelagert wird, wenn der VRAM überläuft. Der Effekt ist einfach bei GPUs mit <3GB zu beobachten, bei denen die Nutzung des System-RAMs gegenüber GPU mit mehr VRAM ansteigt.

Bei den Konsolen gibt es diese Auslagerung nicht.

PCs haben auch ein anderes Speicherkonzept. Da läuft eh erst mal alles über den Hauptspeicher und von dort ins GPU Ram. Ist also gar nicht zu vergleichen.

Dazu bietet die SSD eine viel größere RAM-Disk. bei den Next-Gen Konsolen als es das normale RAM zulassen würde.

Weiterhin wird natürlich der Systembus beim Übertragen der Daten vom RAM ins VRAM belastet, Das ist der Grund dafür, dass man es eben bemerkt, da das Systemram im Vergleich zum VRAM sehr langsam ist und es hier zu kollisionen mit CPU Zugriffen auf den Systembus kommt..

Bei den Next,-Gen Konsolen ist das aber nicht der Fall, Hier wird nur der Gesamtbus beim Kopieren von SSD in den Speicher belastet. Da der aber mit um die 500GB/s oder höher arbeiten wird, fallen die 4-5GB/s der SSD-Transferrate nicht ins Gewicht.

Das ist prinzipiell richtig, nur bringen unterschiedliche GPUs ihre theoretische float-point-Leistung unterscheidlich auf die Straße.

Es hängt auch nicht nur mit der Effizienz zusammen. Wenn es danach ginge, müsste z,b die GPUs der 360 Ära ja unter einer miserablen Effizenz gelitten haben. Denn Navi z.B. wird wohl pro Flop vermutlich das dreifache Leisten. Aber bereits die X360 GPU war schon sehr effizient und brachte mehr als 90% ihrer Leistung auf die Straße.

Neue GPUs haben mehr Recheneinheiten in ihren Shadern, so dass sie mehr und unterschiedliche Dinge berechnen können. Nur ist davon eben nicht alles als Flop deklarierbar.

Eindeutig ist natürlich die doppelte 16bit Performance ggü. den Vorgängerchips. Aber das ist eben nur ein neuer Faktor, der dazu noch kaum Transistoren kostet.