TheProphet

L99: LIMIT BREAKER

- Seit

- 30 Apr 2002

- Beiträge

- 66.470

Sieht nicht gut für die PS5 aus was den Stromverbrauch angeht mit ihren 2200MHz. Kein Wunder, dass sie so einen großen Turm gebaut haben, das muss auch gekühlt werden.Du solltest dir mal GPUs mit taktzahlen ab 2GHz anschauen und was sie Strom verbrauchen/sparen wenn man nur paar % reduziert.

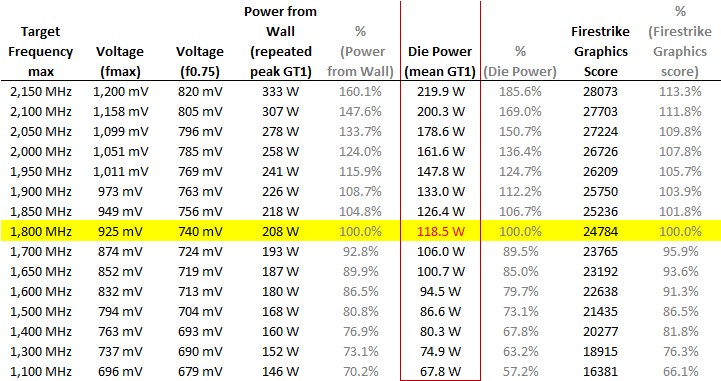

Das ist Navi und geht nicht mal bis 2.23Ghz was locker 200% verbrauch wären gegenüber ihrer 100% bei 1.8Ghz

Und du willst 230mhz runter wenn man nur 10% von der gesamt power sparen müsste in dem fall? Ok

Und ja sie betreiben diesen aufwand, weil Smart shift möglich macht wovon man davor in konsolen nur geträumt hat beim takt.

RDNA2 ist allerdings effizienter, man darf also hoffen, dass der Chip für die Taktraten nicht eine so hohe Spannung benötigt wie der Vorgänger...