@Bomberman82

Gerade das letzte Bid, WTF was geht den da ab ...

Ich bin doch schon extrem gespannt wie gut die PS6 GPU Einheit sein wird.

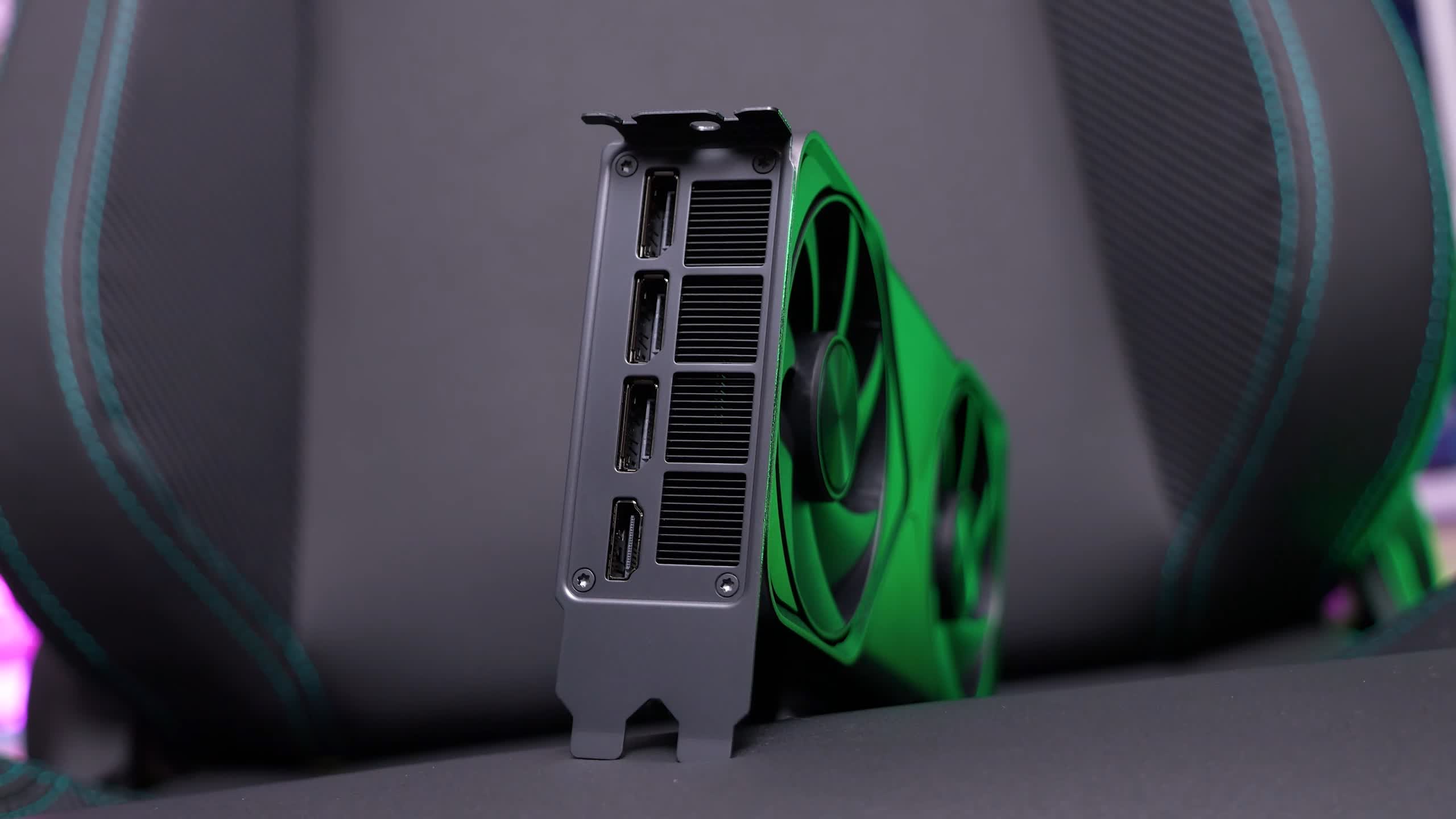

Die RX9060.

Auffällig ist weiterhin, dass die kleinere Radeon RX 9060 bei noch keinem der Boardpartner in Erscheinung getreten ist, wobei diese höchstwahrscheinlich auch erst nach der Radeon RX 9070 und RX 9070 XT das Licht der Welt erblicken wird ... Computerbase.

AMD hat sich nun einen Namen gemacht mit der Serie.

Die RTX 6xxx muss schon abgehen wie Sau, mit echter Rechenleistung. MF ist klar ein Image Schaden für NV.

AMD Radeon RX 9060 XT: Zwei VRAM-Varianten – 8 GB und 16 GB geplant

Na, das riecht doch verdächtig nach einer Kopie von NVIDIAs Strategie. Laut aktuellen EEC-Listings wird die kommende Radeon RX 9060 XT in zwei Versionen erscheinen: eine mit 8 GB und eine mit 16 GB…

www.igorslab.de

Mal sehen was Sony nehmen wird

), nicht bei dem rangezoomten bild, aber davor. Was sind deine RT settings, bzw. ist das überhaupt mit RT? -RT kann manchmal auch seltsam aussehen in dem Game.

), nicht bei dem rangezoomten bild, aber davor. Was sind deine RT settings, bzw. ist das überhaupt mit RT? -RT kann manchmal auch seltsam aussehen in dem Game. -Der Grafikkartenmarkt ist einfach im Eimer, ich denke in nem halben Jahr wird sich das alles etwas beruhigt haben, hoffentlich.

-Der Grafikkartenmarkt ist einfach im Eimer, ich denke in nem halben Jahr wird sich das alles etwas beruhigt haben, hoffentlich.