FatalFury

L15: Wise

- Seit

- 4 Jul 2017

- Beiträge

- 8.958

Also ich warte erstmal:

Keine reinen Daten nur mit DLSS:

Ich hab es der Lederjacke angesehen, da stimmt was nicht und jeder mit einer 660watt GPU ist ein Beta Tester pinonier. Nicht mal profi Internet seiten haben da Ahnung mit.

Sollte aber dennoch alles gut laufen hol ich auch die Standard 4090, die OC Modelle fressen bestimmt um die 700 Watt allein.

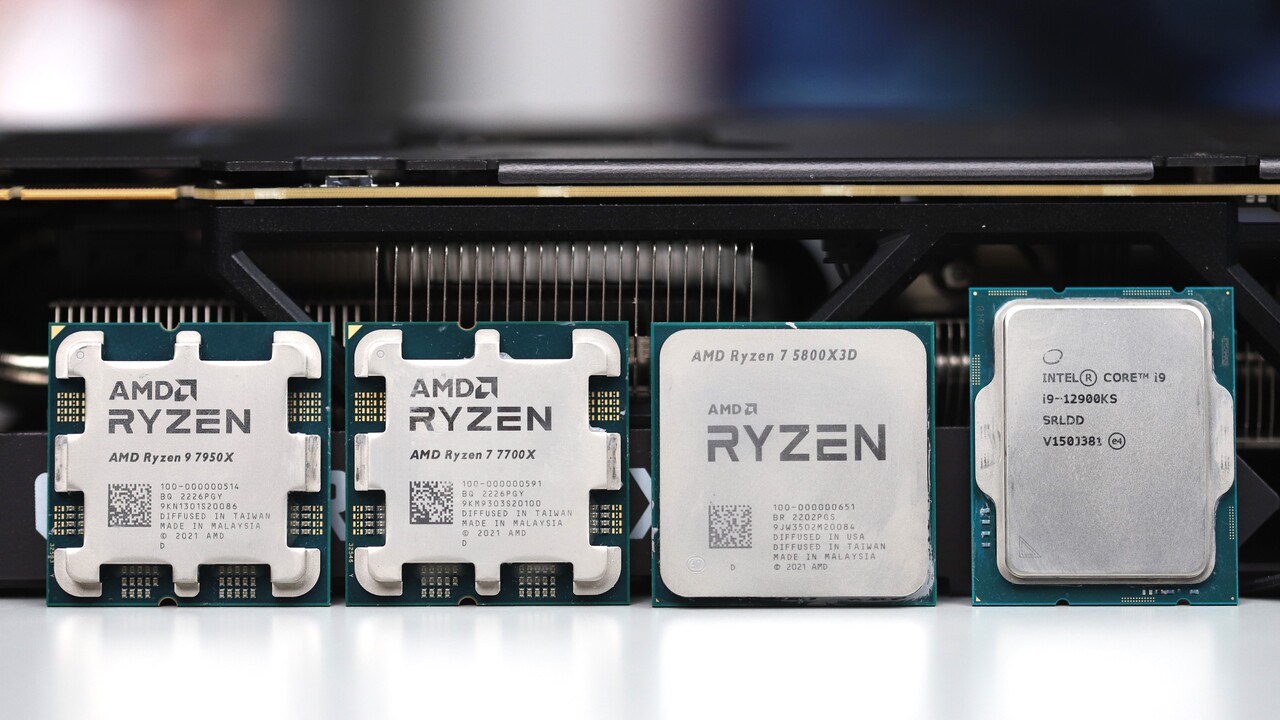

A) 7950x und die 2080Ti

Oder

B) 8700k und die 4090

Das sind meine Möglichkeiten und ich müsste da wählen.

Keine reinen Daten nur mit DLSS:

Ich hab es der Lederjacke angesehen, da stimmt was nicht und jeder mit einer 660watt GPU ist ein Beta Tester pinonier. Nicht mal profi Internet seiten haben da Ahnung mit.

Sollte aber dennoch alles gut laufen hol ich auch die Standard 4090, die OC Modelle fressen bestimmt um die 700 Watt allein.

A) 7950x und die 2080Ti

Oder

B) 8700k und die 4090

Das sind meine Möglichkeiten und ich müsste da wählen.

Zuletzt bearbeitet: