PlayerOne

L15: Wise

- Seit

- 2 Apr 2007

- Beiträge

- 7.560

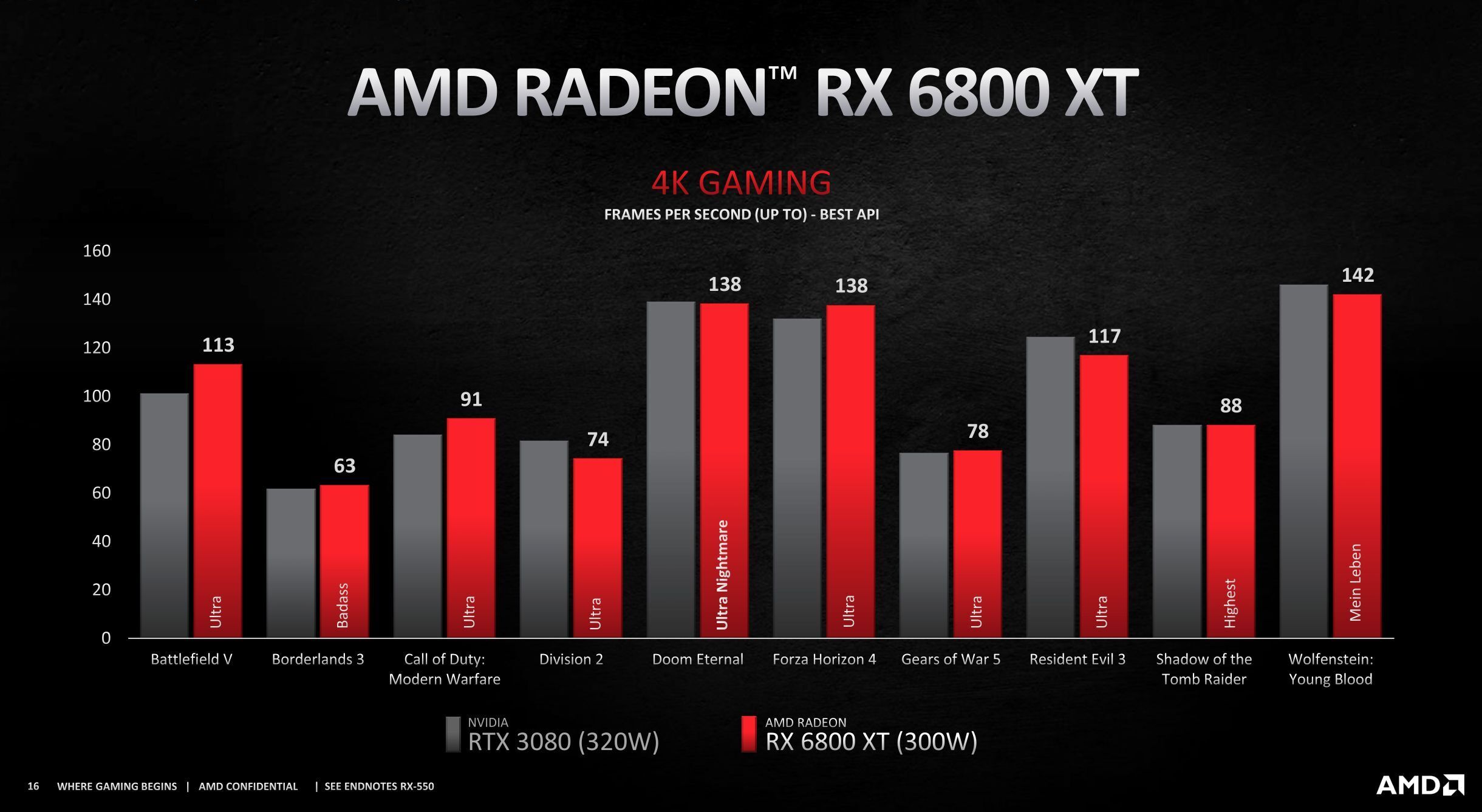

alle kartens schneller als ne 2080tikeine GPU unter 579 ist ein bisschen enttäuschend finde ich

vor 2-3 monaten hat das keiner erwartet nicht mal im ansatz da war 2080ti leistung für big big navi die grenze

vorallem da AMD nicht an der fertigungs verändert hat es si9nd immer noch die 7nm

Sieht gut aus bei AMD, die Preise gefallen mir.

Aber wie das ganze aussieht, wenn RT und DLSS dazu kommen, werden wir dann in echten Vergleichen sehen

6800tx soll im rt scheinbar langsamer sein als ampere aber immerhin schneller als turing wie erwartet

6800 XT = 471fps

RTX 3080 TUF = 630 FPS

RTX 2080Ti = 314 FPS

RTX 2080 = 307 FPS

RTX 2060 @2085 = 242 FPS

imo auch interessant für die konsolen spieler

at RT kerneAMD tells me it's working on its own super sampling technology, similar to Nvidia's DLSS. It will be open and cross-platform, which could mean it'll come to Xbox Series X and PS5. DLSS is a game changer for Nvidia, so this could be big news.

AMD is not using some CUs for raytracing with having the rest for rasterization, but dedicated hw units called Ray Accelerators. One RA per CU. The RA handles the intersection of rays much faster compared to a software implementation. 471 vs 34 FPS in a sample application.

Zuletzt bearbeitet:

(wobei mir aufgefallen ist, dass sie bei der Grafik der 6900XT vs 3090 keine TDP dazuschreiben, wahrscheinlich weils eben keine 300W mehr waren nach Rage Mode)

(wobei mir aufgefallen ist, dass sie bei der Grafik der 6900XT vs 3090 keine TDP dazuschreiben, wahrscheinlich weils eben keine 300W mehr waren nach Rage Mode)