zzz79

L13: Maniac

- Seit

- 7 Feb 2013

- Beiträge

- 3.631

Ich weiß dass die bauen Fanbois jetzt aufschreien werden bei dem Link aber Fakten bleiben Fakten

Xbox Series X: Velocity Architecture mit schneller SSD wird einen deutlichen Unterschied machen laut Entwickler

Xbox Series X: Velocity Architecture mit schneller SSD wird einen deutlichen Unterschied machen laut Entwickler - XboxDynasty.dewww.xboxdynasty.de

Einer technischen Analyse zufolge, ist es sogar möglich, bis zu 100 GB Assets direkt von der SSD zu streamen!

Ujjj wieder nur die 100 GB und das von der größten MS fanboi seite.

dazu die schwachsinnige Formulierung "bis zu 100 GB Assets direkt von der SSD zu streamen!" ... genau und die 100GB streamt die XSX wohn in einen 16 GB RAM, ooops sorry 10 GB RAM (weil nur dieser dezidiert für die GPU ist)

Die XSX kann dank der "Velocity Architecture" einen Berich von 100 GB der SSD für dieses "high speed" streaming nutzen.

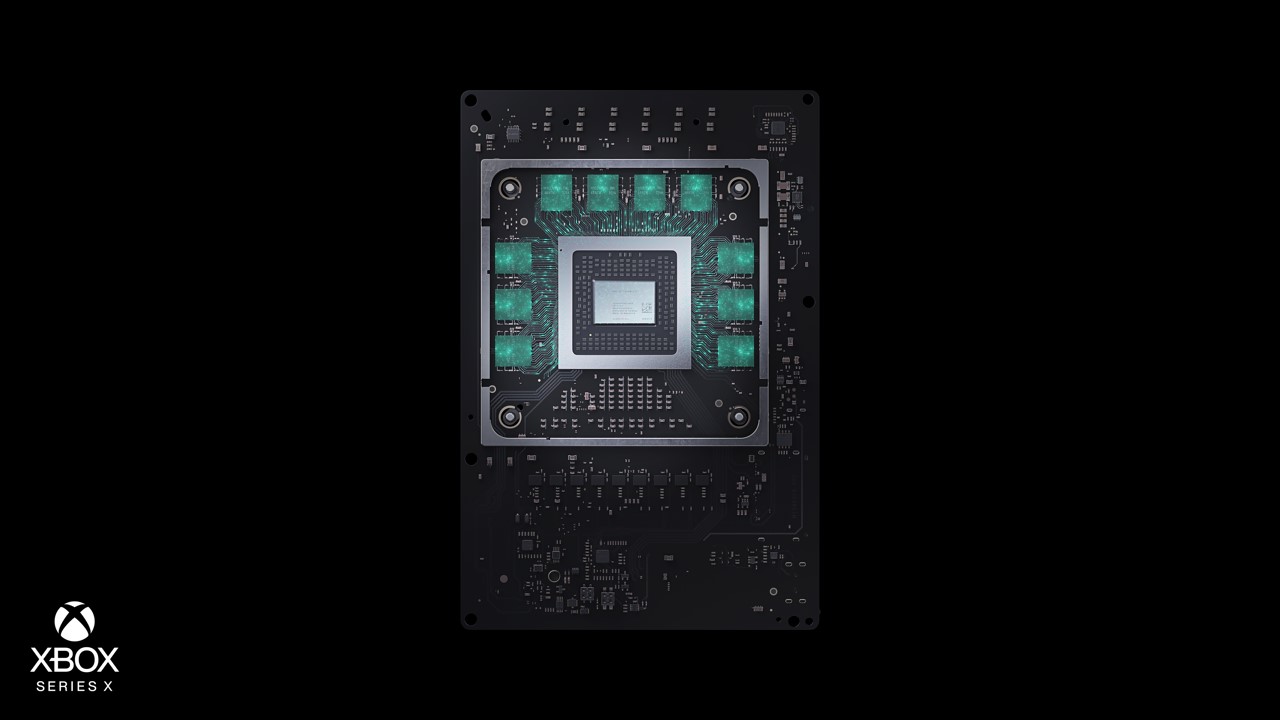

The form factor is cute, the 2.4GB/s of guaranteed throughput is impressive, but it's the software APIs and custom hardware built into the SoC that deliver what Microsoft believes to be a revolution - a new way of using storage to augment memory (an area where no platform holder will be able to deliver a more traditional generational leap). The idea, in basic terms at least, is pretty straightforward - the game package that sits on storage essentially becomes extended memory, allowing 100GB of game assets stored on the SSD to be instantly accessible by the developer. It's a system that Microsoft calls the Velocity Architecture and the SSD itself is just one part of the system.

Der restliche SSD Plattenbereich wird vom I/O und MemoryController nicht für "high speed" streaming unterstützt ?

Während bei der Speedstation 5 der volle SSD-Speicherbeireich für ultra high speed streaming unterstützt wird und das doppelt so schnell

Zuletzt bearbeitet: